El filtro burbuja: ¿‘Un mundo feliz’?

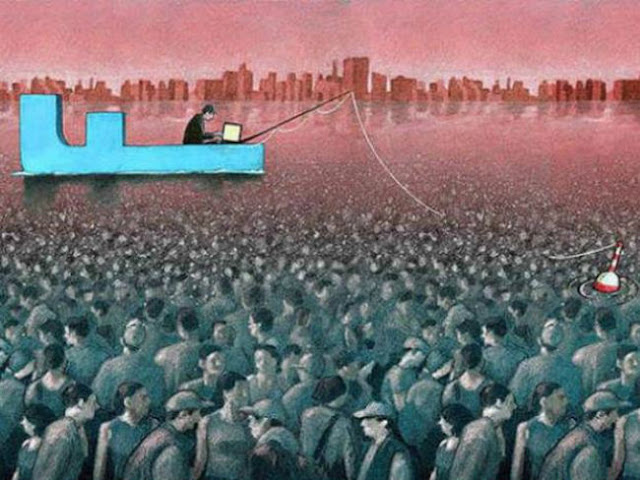

Vivimos en internet, somos datos para miles de algoritmos y las grandes empresas hacen negocio con ellos. La personalización de los contenidos crea un entorno ficticio afín a nuestras ideas. Pero hay resistencia. La libertad está en juego

Vanesa Jiménez / José Luis Marín

Vanesa Jiménez / José Luis Marín

¡Oh qué maravilla!

¡Cuántas criaturas bellas hay aquí!

¡Cuán bella es la humanidad! Oh mundo feliz,

en el que vive gente así.

La Tempestad, Capítulo V

Durante cuatro meses de 1932 Aldous Huxley escribió Un mundo feliz, su novela más famosa, una ficción distópica sobre una sociedad sometida por la ciencia a la satisfacción plena. Aquel cosmos de cultivos humanos, predestinación y ausencia de libre albedrío se fraguó en una época en la que los totalitarismos pugnaban por dominar una parte del mundo. Cerebros condicionados y ayudados por el soma, una droga ideada para curar la melancolía (“si por desgracia se abriera alguna rendija de tiempo en la sólida sustancia de sus distracciones, siempre queda el soma: medio gramo para una de asueto, un gramo para fin de semana, dos gramos para viajar al bello Oriente, tres para una oscura eternidad en la Luna”), componían la sociedad perfecta con la que Huxley ironizó contra las tiranías. Aquel mundo feliz era ciencia ficción. Sí. Pero también apuntaba futuros posibles. La vida digital nos está acercando a algunos de ellos.

Hace varias semanas se publicó en español The Filter Bubble. What The Internet Is Hiding From You (Penguin), una investigación de Eli Pariser (Maine, Estados Unidos, 1980) sobre cómo los grandes sitios de internet en los que buscamos información, nos relacionamos y nos informamos iniciaron el camino de la personalización de contenidos y, con él, el de la recopilación de nuestros datos personales. De “cómo la red decide lo que leemos y lo que pensamos”.

El libro arranca con una fecha, el 4 de diciembre de 2009. Aquel día, sin apenas difusión, Google cambió su algoritmo de búsqueda: “Búsquedas personalizadas para todos”, tituló un blog tecnológico. Hasta entonces, el criterio principal era el del Pagerank —el nombre viene del de uno de los fundadores de Google, Larry Page—, una serie de fórmulas que permitían asignar relevancia a los documentos de forma numérica. La pauta de pertinencia para el buscador era el número de enlaces de otras páginas. Y la lógica era pensar que todos veíamos los mismos resultados ante la misma búsqueda.

el gran buscador se convirtió en millones de buscadores distintos. Empezábamos a encontrar lo que somos según los datos que Google conoce de nosotros

Hace varias semanas se publicó en español The Filter Bubble. What The Internet Is Hiding From You (Penguin), una investigación de Eli Pariser (Maine, Estados Unidos, 1980) sobre cómo los grandes sitios de internet en los que buscamos información, nos relacionamos y nos informamos iniciaron el camino de la personalización de contenidos y, con él, el de la recopilación de nuestros datos personales. De “cómo la red decide lo que leemos y lo que pensamos”.

El libro arranca con una fecha, el 4 de diciembre de 2009. Aquel día, sin apenas difusión, Google cambió su algoritmo de búsqueda: “Búsquedas personalizadas para todos”, tituló un blog tecnológico. Hasta entonces, el criterio principal era el del Pagerank —el nombre viene del de uno de los fundadores de Google, Larry Page—, una serie de fórmulas que permitían asignar relevancia a los documentos de forma numérica. La pauta de pertinencia para el buscador era el número de enlaces de otras páginas. Y la lógica era pensar que todos veíamos los mismos resultados ante la misma búsqueda.

el gran buscador se convirtió en millones de buscadores distintos. Empezábamos a encontrar lo que somos según los datos que Google conoce de nosotros

El algoritmo de Google y el librero de Amazon

A finales de 2009, Google modificó su algoritmo para mostrar aquello que cree estamos buscando. En aquel cambio —la compañía llega a variar su motor más de 500 veces al año, aunque muy pocas veces la transformación es importante— sus ingenieros introdujeron una serie de indicadores personales (búsquedas anteriores, lugar de conexión, tipo de navegador…) y el gran buscador se convirtió en millones de buscadores distintos. Empezábamos a encontrar lo que somos según los datos que Google conoce de nosotros. Pero, ¿y si buscamos algo diferente? O, ¿por qué nunca veremos aquello que a priori no nos interesa? El filtro burbuja —acuñado por Pariser— comenzaba a configurarse.

El funcionamiento es sencillo: si buscas esto, la próxima vez te daré lo mismo. Si normalmente lees o compartes noticias de determinados medios, verás estos medios en tus redes. Si lees un libro o ves una película, la próxima vez tendrás destacado al mismo autor o director, o algunos similares. Si sueles viajar de Madrid a Londres encontrarás ofertas de vuelos personalizadas…

También predestinamos y condicionamos. Decantamos nuestros críos como seres humanos socializados [...] Observen, crecerán con lo que los psicólogos solían llamar un odio instintivo hacia los libros y hacia las flores. Reflejos condicionados definitivamente. Estarán a salvo de la botánica y de los libros para toda su vida.

Un mundo feliz. Capítulo II.

Los contenidos adaptados de Google, pero también de Facebook, Apple, Amazon, Netflix o de muchos sitios de noticias permiten un mundo feliz individual, un caudal inmenso de información que nos representa, con la que nos sentimos cómodos. En la burbuja de filtros no vemos aquello que el programa establece que no nos interesa. Tampoco somos conscientes de que esa información existe, o de que puede que haya algo importante que nos estemos perdiendo. Y, sin esa otra visión, sin esa experiencia crítica, el mundo de pronto se hace mucho más pequeño; con la ficción añadida de creer que tenemos un acceso libre y colosal a lo que ocurre.

— Para lo que está destinado, sí. — Se encogió de hombros Helmholtz—. Pero su destino, ¡es tan poco trascendente! ¿De qué sirve que te penetre un artículo sobre un Canto de Comunidad, o la última mejora en los órganos de perfumes? Además, ¿es posible hacer que las palabras sean penetrantes como los rayos X cuando se escribe acerca de cosas como éstas? ¿Cabe decir algo acerca de nada? A fin de cuentas, éste es el problema.

Un mundo feliz. Capítulo VI

El cambio en Google fue, según Pariser, el inicio de la personalización masiva, pero fue Jezz Bezos con Amazon el primero que supo explotar la idea de la relevancia. La esencia de su proyecto se resumía en una frase que el magnate —hoy dueño de The Washington Post y tercer hombre más rico del mundo según la lista Forbes— repetía: “Quiero devolver la venta de libros por internet a los tiempos en que uno iba a la librería de toda la vida y el librero, que te conocía perfectamente, te decía: ‘Sé que te gusta John Irving y acaba de salir un nuevo escritor que me lo recuerda mucho. Creo que este libro te va a gustar”.

Desde el principio, Amazon fue una librería con personalización incorporada. En 1997 vendió el primer millón de libros. En 2001 consiguió su primer trimestre de beneficio neto. Y en los tres primeros meses de este año, su cifra de negocio alcanzó los 32.720 millones de euros, un 22,6% más respecto al mismo periodo de 2016.

El funcionamiento es sencillo: si buscas esto, la próxima vez te daré lo mismo. Si normalmente lees o compartes noticias de determinados medios, verás estos medios en tus redes. Si lees un libro o ves una película, la próxima vez tendrás destacado al mismo autor o director, o algunos similares. Si sueles viajar de Madrid a Londres encontrarás ofertas de vuelos personalizadas…

También predestinamos y condicionamos. Decantamos nuestros críos como seres humanos socializados [...] Observen, crecerán con lo que los psicólogos solían llamar un odio instintivo hacia los libros y hacia las flores. Reflejos condicionados definitivamente. Estarán a salvo de la botánica y de los libros para toda su vida.

Un mundo feliz. Capítulo II.

Los contenidos adaptados de Google, pero también de Facebook, Apple, Amazon, Netflix o de muchos sitios de noticias permiten un mundo feliz individual, un caudal inmenso de información que nos representa, con la que nos sentimos cómodos. En la burbuja de filtros no vemos aquello que el programa establece que no nos interesa. Tampoco somos conscientes de que esa información existe, o de que puede que haya algo importante que nos estemos perdiendo. Y, sin esa otra visión, sin esa experiencia crítica, el mundo de pronto se hace mucho más pequeño; con la ficción añadida de creer que tenemos un acceso libre y colosal a lo que ocurre.

— Para lo que está destinado, sí. — Se encogió de hombros Helmholtz—. Pero su destino, ¡es tan poco trascendente! ¿De qué sirve que te penetre un artículo sobre un Canto de Comunidad, o la última mejora en los órganos de perfumes? Además, ¿es posible hacer que las palabras sean penetrantes como los rayos X cuando se escribe acerca de cosas como éstas? ¿Cabe decir algo acerca de nada? A fin de cuentas, éste es el problema.

Un mundo feliz. Capítulo VI

El cambio en Google fue, según Pariser, el inicio de la personalización masiva, pero fue Jezz Bezos con Amazon el primero que supo explotar la idea de la relevancia. La esencia de su proyecto se resumía en una frase que el magnate —hoy dueño de The Washington Post y tercer hombre más rico del mundo según la lista Forbes— repetía: “Quiero devolver la venta de libros por internet a los tiempos en que uno iba a la librería de toda la vida y el librero, que te conocía perfectamente, te decía: ‘Sé que te gusta John Irving y acaba de salir un nuevo escritor que me lo recuerda mucho. Creo que este libro te va a gustar”.

Desde el principio, Amazon fue una librería con personalización incorporada. En 1997 vendió el primer millón de libros. En 2001 consiguió su primer trimestre de beneficio neto. Y en los tres primeros meses de este año, su cifra de negocio alcanzó los 32.720 millones de euros, un 22,6% más respecto al mismo periodo de 2016.

— ¿Por qué, en lugar de esto, no les permite leer Otelo?

— Ya se lo he dicho: es antiguo. Además, no lo entenderían.

Un mundo feliz. Capítulo XVI

Un mundo feliz. Capítulo XVI

Acxiom, los datos y el 11S

La ficción utópica de acceso absoluto al todo tiene otro atractivo añadido: el gratis casi total. No solo tengo lo que quiero, además lo tengo de forma gratuita o por muy poco. La rentabilidad está en un elemento que no es evidente pero que podemos intuir, y son nuestros datos personales. En el negocio de la información personal no solo están las compañías tecnológicas más reconocibles. Pariser destaca en su libro a Acxiom, una empresa desconocida para el gran público que controla los datos del 96% de los hogares estadounidenses y de 700 millones de personas de todo el mundo. Saben sus nombres, sus direcciones, sus facturas, si toman algún medicamento, si tienen mascota…

Acxiom buscó en sus enormes bases de datos y resultó que sabía más sobre 11 de los 19 secuestradores que el Gobierno de Estados Unidos

Durante la mayor parte de su vida, Acxiom ha mantenido un perfil bajo, pero tras el 11S jugó un papel público importante. Según cuenta Pariser en su libro, el 14 de septiembre de 2001, pocas horas después de que se hicieran públicos los nombres de los terroristas, el FBI recibió la llamada de un antiguo funcionario de la Casa Blanca que en ese momento era directivo de Acxiom. A partir de ahí la empresa buscó en sus enormes bases de datos y resultó que sabía más sobre 11 de los 19 secuestradores que el Gobierno de Estados Unidos.

Acxiom explica en su web que “proporciona la Base de Datos —así en mayúscula— a los mejores vendedores del mundo”. Y añade: “Creemos que los datos son la clave para crear interacciones significativas a escala entre los consumidores y las marcas que aman”.

En febrero de este año, la compañía, con sede en Conway, Arkansas, anunció el cese de sus operaciones en España por las “estrictas leyes sobre protección de datos”. “Ha sido extremadamente difícil desarrollar y vender nuestras soluciones de una forma comercialmente viable”, explicó la empresa en un comunicado.

Acxiom buscó en sus enormes bases de datos y resultó que sabía más sobre 11 de los 19 secuestradores que el Gobierno de Estados Unidos

Durante la mayor parte de su vida, Acxiom ha mantenido un perfil bajo, pero tras el 11S jugó un papel público importante. Según cuenta Pariser en su libro, el 14 de septiembre de 2001, pocas horas después de que se hicieran públicos los nombres de los terroristas, el FBI recibió la llamada de un antiguo funcionario de la Casa Blanca que en ese momento era directivo de Acxiom. A partir de ahí la empresa buscó en sus enormes bases de datos y resultó que sabía más sobre 11 de los 19 secuestradores que el Gobierno de Estados Unidos.

Acxiom explica en su web que “proporciona la Base de Datos —así en mayúscula— a los mejores vendedores del mundo”. Y añade: “Creemos que los datos son la clave para crear interacciones significativas a escala entre los consumidores y las marcas que aman”.

En febrero de este año, la compañía, con sede en Conway, Arkansas, anunció el cese de sus operaciones en España por las “estrictas leyes sobre protección de datos”. “Ha sido extremadamente difícil desarrollar y vender nuestras soluciones de una forma comercialmente viable”, explicó la empresa en un comunicado.

—

Mi joven y querido amigo — dijo Mustafá Mond—, la civilización no tiene

ninguna necesidad de nobleza ni de heroísmo. Ambas cosas son síntomas

de ineficacia política. En una sociedad debidamente organizada como la

nuestra, nadie tiene la menor oportunidad de comportarse noble y

heroicamente. Las condiciones deben hacerse del todo inestables antes de

que surja tal oportunidad. Donde hay guerras, donde hay una dualidad de

lealtades, donde hay tentaciones que resistir, objetos de amor por los

cuales luchar o que defender, allá, es evidente, la nobleza y el

heroísmo tienen algún sentido. Pero actualmente no hay guerras. Se toman

todas las precauciones posibles para evitar que cualquiera pueda amar

demasiado a otra persona.

Un mundo feliz. Capítulo XVII

Un mundo feliz. Capítulo XVII

El grafo social

En la primera conferencia mundial auspiciada por Facebook, celebrada en San Francisco el 24 de mayo de 2007, Mark Zuckerberg, fundador de la compañía, lanzó la idea del grafo social: el conjunto de relaciones de cada persona. Facebook no era la primera red social, pero sí la que antes utilizó un algoritmo de selección de noticias que recopilaba las actualizaciones de sus usuarios. “Estamos generando más noticias en un solo día para nuestros 19 millones de usuarios que las que generó cualquier otro medio de comunicación en toda su existencia”, proclamó Zuckerberg.

En el Facebook más primitivo, el muro mostraba todo —o casi— lo que tus amigos compartían en su página. Pero esto fue pronto incontrolable por el volumen. Así nació un algoritmo basado en tres factores (afinidad, actualización y tiempo) que permitió acumular y discriminar información del usuario para que el sistema funcionase. Un ciclo infinito. Cuantos más datos se tengan, más sofisticados tienen que ser los algoritmos para organizarlos.

El 27 de junio de este año, Zuckerberg anunció en un post en Facebook que la comunidad había alcanzando oficialmente los dos mil millones de personas. “Estamos haciendo progresos conectando el mundo, y ahora lo vamos a acercar todos juntos. Es un honor estar en este viaje contigo”. El objetivo de la empresa que había creado trece años antes se estaba cumpliendo. Facebook ya está en casi todas partes. Su capacidad de censura también.

En el Facebook más primitivo, el muro mostraba todo —o casi— lo que tus amigos compartían en su página. Pero esto fue pronto incontrolable por el volumen. Así nació un algoritmo basado en tres factores (afinidad, actualización y tiempo) que permitió acumular y discriminar información del usuario para que el sistema funcionase. Un ciclo infinito. Cuantos más datos se tengan, más sofisticados tienen que ser los algoritmos para organizarlos.

El 27 de junio de este año, Zuckerberg anunció en un post en Facebook que la comunidad había alcanzando oficialmente los dos mil millones de personas. “Estamos haciendo progresos conectando el mundo, y ahora lo vamos a acercar todos juntos. Es un honor estar en este viaje contigo”. El objetivo de la empresa que había creado trece años antes se estaba cumpliendo. Facebook ya está en casi todas partes. Su capacidad de censura también.

—

En suma — dijo Mustafá Mond—, usted reclama el derecho a ser

desgraciado.

— Muy bien, de acuerdo — dijo el Salvaje, en tono de reto—.

Reclamo el derecho a ser desgraciado.

— Esto, sin hablar del derecho a

envejecer, a volverse feo e impotente, el derecho a tener sífilis y

cáncer, el derecho a pasar hambre, el derecho a ser piojoso, el derecho a

vivir en el temor constante de lo que pueda ocurrir mañana; el derecho a

pillar un tifus; el derecho a ser atormentado.

Un mundo feliz. Capítulo XVII

Un mundo feliz. Capítulo XVII

Rompiendo las burbujas

En paralelo a los filtros burbuja ha nacido una especie de resistencia que empieza a crecer tanto como el enemigo a batir: desde simples bloqueadores de publicidad a prácticas de hackeo avanzadas. En el caso de Facebook y otras redes sociales, también existen herramientas para romper la imposición de los contenidos.

Escape Your Bubble, desarrollada por el ingeniero neoyorquino Krishna Kaliannan, tiene como objetivo pinchar la burbuja que Facebook genera según la experiencia política de cada persona. Funciona gracias a una extensión de Google Chrome que reemplaza ciertos posts publicitarios por contenidos políticos de calidad contrarios a la filiación del usuario. En la herramienta se elige sobre qué partido político se quiere saber más —republicanos o demócratas— y se indica la postura que se tiene en torno a cuestiones sociales y económicas, además de la creencia (o no) religiosa. A partir de ahí, el muro mostrará distintas entradas, identificadas con una banda rosa y un logo de la herramienta —una especie de recordatorio de que tu filtro está siendo atravesado— con información que, por la experiencia y comportamiento, hubiese sido descartada o simplemente ocultada por el algoritmo.

La situación es muy grave para una red en la que, en principio, están registradas cerca de 2 de cada 7 personas del planeta. Establecer un sistema de control de discursos transnacional plantea situaciones muy completas, pero que los términos en los que se muestra el cuestionario filtrado –hombres blancos vs menores negros– provoca un incendio de enromes proporciones en el debate.

La idea, muy simple, no deja de ser paradójica: a través de dos de los principales sistemas de filtros de Facebook, las extensiones de Google y el sistema de Ads (publicidad), se rompe el filtro mismo.

Escape Your Bubble no es un caso aislado. Hay varias herramientas que comienzan a funcionar contra la uniformidad informativa. Flipfeed, una extensión desarrollada por el MIT Media Lab, permite que nuestras cuentas de Twitter tomen el feed —las fuentes, los seguidores o la información seleccionada— de otro usuario y que aparezca en nuestro perfil como propio. De esta forma, y también de acuerdo a una clasificación política de los usuarios, podemos ponernos en el lugar —y en el uso que hace de las redes— de personas alejadas ideológicamente. PolitEcho, que también funciona a través de un pluging de Chrome, ayuda a reconocer en Facebook los sesgos propios a través de una comparación con nuestros contactos. Algo así como una herramienta que categoriza y describe nuestra propia burbuja.

los seguidores de Hillary Clinton estaban convencidos de la victoria de su candidata. No solo porque era lo que deseaban, sino porque su filtro burbuja se encargó de que esa fuese la ‘realidad’ que veían

El debate sobre la censura, el control y la direccionalidad de los contenidos en internet cobró especial relevancia tras la victoria de Donald Trump, cuando las redes se inundaron de noticias falsas y complejos entramados de hackeo e intromisión política. Lo más notorio fue, quizá, el convencimiento acérrimo que demostraron los seguidores de Hillary Clinton en la victoria de su candidata, incluso en los minutos inmediatamente previos a que se conociesen los resultados finales. No solo porque era lo que deseaban, sino porque su filtro burbuja se encargó de que esa fuese la ‘realidad’ que veían.

A finales de 2015, Natalie Fenton, activista y profesora de Comunicación en Goldsmiths, University of London, reflexionaba en ese sentido en una entrevista publicada en CTXT: “Lejos de aumentar la participación política de todos, internet crea guetos políticos de los que ya están bien informados; afianza las desigualdades que existen offline. Esto me sucedió durante las elecciones del Reino Unido, donde me dejé seducir por esta idea de que en la tuitesfera y en Facebook todo se sentía bien, había un montón de buenos debates, se sentía cómo la izquierda iba ganando terreno. Pero, por supuesto, todo lo que estaba haciendo era hablar con mis amigos”.

Escape Your Bubble, desarrollada por el ingeniero neoyorquino Krishna Kaliannan, tiene como objetivo pinchar la burbuja que Facebook genera según la experiencia política de cada persona. Funciona gracias a una extensión de Google Chrome que reemplaza ciertos posts publicitarios por contenidos políticos de calidad contrarios a la filiación del usuario. En la herramienta se elige sobre qué partido político se quiere saber más —republicanos o demócratas— y se indica la postura que se tiene en torno a cuestiones sociales y económicas, además de la creencia (o no) religiosa. A partir de ahí, el muro mostrará distintas entradas, identificadas con una banda rosa y un logo de la herramienta —una especie de recordatorio de que tu filtro está siendo atravesado— con información que, por la experiencia y comportamiento, hubiese sido descartada o simplemente ocultada por el algoritmo.

La situación es muy grave para una red en la que, en principio, están registradas cerca de 2 de cada 7 personas del planeta. Establecer un sistema de control de discursos transnacional plantea situaciones muy completas, pero que los términos en los que se muestra el cuestionario filtrado –hombres blancos vs menores negros– provoca un incendio de enromes proporciones en el debate.

La idea, muy simple, no deja de ser paradójica: a través de dos de los principales sistemas de filtros de Facebook, las extensiones de Google y el sistema de Ads (publicidad), se rompe el filtro mismo.

Escape Your Bubble no es un caso aislado. Hay varias herramientas que comienzan a funcionar contra la uniformidad informativa. Flipfeed, una extensión desarrollada por el MIT Media Lab, permite que nuestras cuentas de Twitter tomen el feed —las fuentes, los seguidores o la información seleccionada— de otro usuario y que aparezca en nuestro perfil como propio. De esta forma, y también de acuerdo a una clasificación política de los usuarios, podemos ponernos en el lugar —y en el uso que hace de las redes— de personas alejadas ideológicamente. PolitEcho, que también funciona a través de un pluging de Chrome, ayuda a reconocer en Facebook los sesgos propios a través de una comparación con nuestros contactos. Algo así como una herramienta que categoriza y describe nuestra propia burbuja.

los seguidores de Hillary Clinton estaban convencidos de la victoria de su candidata. No solo porque era lo que deseaban, sino porque su filtro burbuja se encargó de que esa fuese la ‘realidad’ que veían

El debate sobre la censura, el control y la direccionalidad de los contenidos en internet cobró especial relevancia tras la victoria de Donald Trump, cuando las redes se inundaron de noticias falsas y complejos entramados de hackeo e intromisión política. Lo más notorio fue, quizá, el convencimiento acérrimo que demostraron los seguidores de Hillary Clinton en la victoria de su candidata, incluso en los minutos inmediatamente previos a que se conociesen los resultados finales. No solo porque era lo que deseaban, sino porque su filtro burbuja se encargó de que esa fuese la ‘realidad’ que veían.

A finales de 2015, Natalie Fenton, activista y profesora de Comunicación en Goldsmiths, University of London, reflexionaba en ese sentido en una entrevista publicada en CTXT: “Lejos de aumentar la participación política de todos, internet crea guetos políticos de los que ya están bien informados; afianza las desigualdades que existen offline. Esto me sucedió durante las elecciones del Reino Unido, donde me dejé seducir por esta idea de que en la tuitesfera y en Facebook todo se sentía bien, había un montón de buenos debates, se sentía cómo la izquierda iba ganando terreno. Pero, por supuesto, todo lo que estaba haciendo era hablar con mis amigos”.

La censura de Facebook

Recientemente, la plataforma ProPublica ha revelado unos documentos internos de Facebook donde se recogen las pautas algorítmicas que la red social ha impuesto en sus mecanismos de censura. La función de esas reglas es, supuestamente, diferenciar los discursos de odio de la libertad de expresión –política– legítima. Sin embargo, el principal descubrimiento fue la discriminación a la que somete Facebook a sus usuarios en términos de protección. Mientras determinados colectivos —como los hombres blancos— son protegidos de los discursos de odio por la normativa, no ocurre lo mismo con otros grupos —por ejemplo, los menores negros—.

—

¡Noventa y seis mellizos trabajando en noventa y seis máquinas

idénticas! — La voz del director casi temblaba de entusiasmo—. Sabemos

muy bien adónde vamos. Por primera vez en la historia. — Citó la divisa

planetaria-: Comunidad, Identidad, Estabilidad.

Un mundo feliz. Capítulo I

Un mundo feliz. Capítulo I

Según ProPublica, los documentos filtrados también sugieren que las normas que impone Facebook tienden a favorecer a determinadas élites o gobiernos frente al activismo de base o las minorías. En parte, esto supondría que los criterios de censura se configuran parcialmente según los intereses comerciales de la compañía, supeditada a la decisión —o amenaza— de determinados gobiernos de bloquear o no la red en sus territorios. Una de las reglas que aparece en esos informes –y que Facebook asegura no usar ya– prohíbe defender la violencia como forma de resistencia ante un Estado reconocido internacionalmente. Esto afectaría a Palestina, Crimea o el Sahara Occidental.

El caso más llamativo en este sentido fue publicado por The Wall Street Journal el año pasado. Según el diario, la afirmación de Donald Trump de prohibir la inmigración musulmana al país no fue censurada por orden directa de Zuckerberg pese al duro debate que suscitó entre los propios empleados de la compañía, que alegaron que violaba las reglas del sitio sobre el discurso de odio.

Otro de los textos filtrados a ProPublica contiene un formulario de formación para que los reguladores de contenido de Facebook aprendan a aplicar las normas de censura. Ante la pregunta “¿qué grupo está protegido de los discursos de odio?”, se proponen tres posibilidades: “Mujeres al volante, niños negros u hombres blancos”. La respuesta correcta es ‘hombres blancos’.

Sexo prohibido

El pasado mes de mayo, el diario británico The Guardian publicó una serie de reportajes —Facebook Files— en los que explicaba de forma detallada las normas internas, los comportamientos de moderación o la permisividad de la red con ciertos contenidos sensibles. Era la primera vez que se conocía, por ejemplo, la política de la compañía sobre contenidos sexuales. De la pornografía al desnudo en el arte. Uno de los documentos, relativo a las pautas de moderación, revelaba que en Facebook se puede publicar “quiero follarte”, pero sin ningún detalle concreto. Una fuente interna lo explicaba así: “Permitimos expresiones generales de deseo, pero no detalles sexuales explícitos”. La empresa asegura que le es “difícil establecer una línea entre contenido sexual aceptable e inaceptable”.

El pasado mes de mayo, el diario británico The Guardian publicó una serie de reportajes —Facebook Files— en los que explicaba de forma detallada las normas internas, los comportamientos de moderación o la permisividad de la red con ciertos contenidos sensibles. Era la primera vez que se conocía, por ejemplo, la política de la compañía sobre contenidos sexuales. De la pornografía al desnudo en el arte. Uno de los documentos, relativo a las pautas de moderación, revelaba que en Facebook se puede publicar “quiero follarte”, pero sin ningún detalle concreto. Una fuente interna lo explicaba así: “Permitimos expresiones generales de deseo, pero no detalles sexuales explícitos”. La empresa asegura que le es “difícil establecer una línea entre contenido sexual aceptable e inaceptable”.Facebook planea ampliar su equipo de moderadores a 7.500 personas en todo el mundo, en la que podría ser la mayor operación de censura de la historia. También la más opaca, ya que la red no publica —solo existen filtraciones— las reglas que sigue para aplicar su filtro burbuja.

Noticias uniformadas y cámaras de eco

Algunos medios de comunicación no están siendo ajenos a los efectos peligrosos de la personalización de los contenidos. El periodismo como servicio público, la información importante, jerarquizada, se oscurece en un mundo de noticias servidas a la carta. El 12 de junio de este año, Chris Evans, director del Daily Telegraph, y Katharine Viner, redactora jefa del Guardian, firmaron un artículo conjunto que publicaron ambos medios. “Desde lados opuestos del espectro político”, los periódicos quisieron alertar sobre el papel de la prensa y los enemigos a los que se enfrenta.

El fragmento final de la columna expresa lo siguiente:

“Nuevas tendencias preocupantes están empezando a afectar a la conciencia pública —noticias falsas, algoritmos sesgados, cámaras de eco (ampliación por transmisión y repetición en un sistema cerrado)—. Los efectos del filtro burbuja pueden aparecer rápidamente a medida que las experiencias segmentadoras que nos llegan de Facebook y Google solo nos sirven noticias y puntos de vista con los que estamos de acuerdo. Estas burbujas pueden llevarnos a estrechar nuestra visión del mundo, en lugar de buscar noticias y opiniones que nos involucren, ensanchen nuestros puntos de vista y nos expongan a nuevas ideas. Con este telón de fondo, nunca ha sido tan importante para la prensa un escrutinio equilibrado, profesional, pero, sobre todo, duro con los líderes políticos de todas las ramas. Mientras el evento Great Get Together se está organizando para este fin de semana en memoria de la vida y obra de Jo Cox, nosotros, los dos editores, no vacilamos al unirnos, aunque sea por un día, para compartir el sutil sentimiento de George Orwell: “Si la libertad significa algo, será, sobre todo, el derecho a decirle a la gente aquello que no quiere oír”.

Internet fue capaz de transformar el mundo. Abrió una ventana casi infinita a las ideas. Solo hace falta corregir el rumbo y reivindicar espacios de pensamiento.

“Nuevas tendencias preocupantes están empezando a afectar a la conciencia pública —noticias falsas, algoritmos sesgados, cámaras de eco (ampliación por transmisión y repetición en un sistema cerrado)—. Los efectos del filtro burbuja pueden aparecer rápidamente a medida que las experiencias segmentadoras que nos llegan de Facebook y Google solo nos sirven noticias y puntos de vista con los que estamos de acuerdo. Estas burbujas pueden llevarnos a estrechar nuestra visión del mundo, en lugar de buscar noticias y opiniones que nos involucren, ensanchen nuestros puntos de vista y nos expongan a nuevas ideas. Con este telón de fondo, nunca ha sido tan importante para la prensa un escrutinio equilibrado, profesional, pero, sobre todo, duro con los líderes políticos de todas las ramas. Mientras el evento Great Get Together se está organizando para este fin de semana en memoria de la vida y obra de Jo Cox, nosotros, los dos editores, no vacilamos al unirnos, aunque sea por un día, para compartir el sutil sentimiento de George Orwell: “Si la libertad significa algo, será, sobre todo, el derecho a decirle a la gente aquello que no quiere oír”.

Internet fue capaz de transformar el mundo. Abrió una ventana casi infinita a las ideas. Solo hace falta corregir el rumbo y reivindicar espacios de pensamiento.

La humanidad más bella siempre es la más libre.

La tiranía siempre es más ordenada que la libertad.

Fuente: http://ctxt.es/es/20170712/Politica/13847/filtro-burbuja-internet-datos-facebook-algoritmos.htm - Imagenes: seopressor.com - PlayGround - Nashville Chatter - Lifehacker - montag